Внимание! Техподдержка работает только через тикет-систему в личном кабинете

Apache Spark – фреймворк для обработки больших данных и машинного обучения на VPS

Фреймворк для распределенной обработки больших данных. Основные возможности: потоковая аналитика, машинное обучение через MLlib, графовая обработка в GraphX и управление партициями, включая apache spark drop partition для оптимизации хранения.

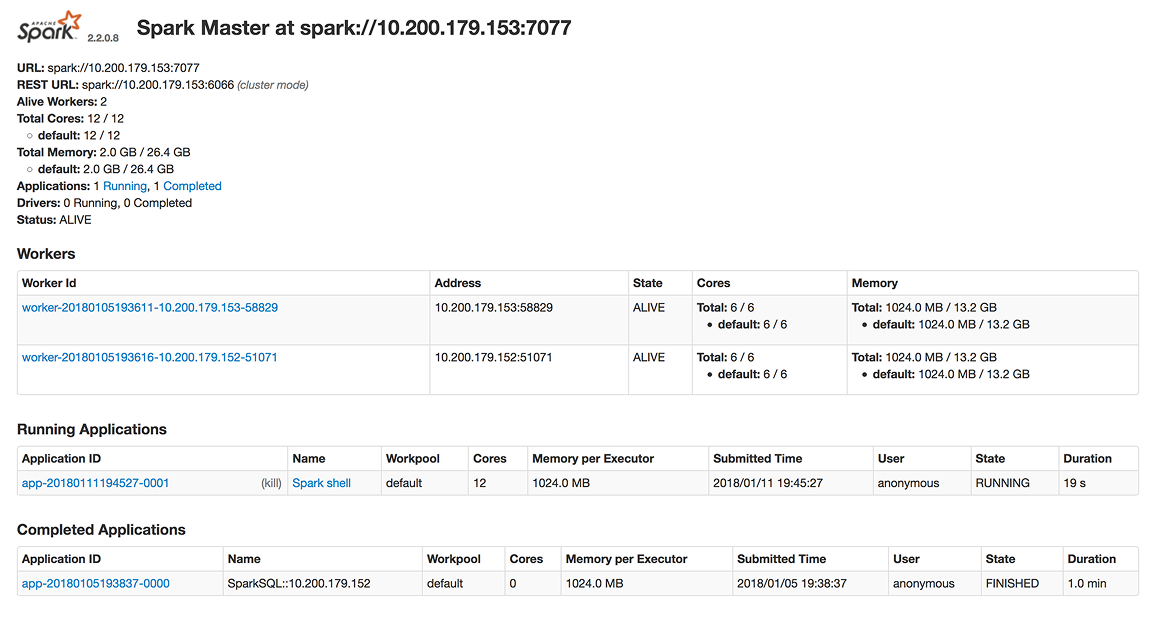

Apache Spark - это распределенная платформа для обработки данных в кластерах. Основное назначение - анализ больших объемов данных, сфера применения включает data engineering, machine learning, DevOps и CI/CD. Ключевые функции: в-memory обработка для ускорения задач, поддержка SQL-запросов через Spark SQL и интеграция с MLlib для алгоритмов обучения. Это делает spark apache универсальным для потоковой аналитики и графов.

Ключевые функции включают: in-memory обработку для ускорения вычислений, Spark SQL для выполнения запросов, библиотеку MLlib для обучения моделей, поддержку потоковых данных через Structured Streaming и анализ графов с помощью GraphX. Всё это делает Apache Spark универсальным инструментом для работы с большими данными в реальном времени.

Установка Apache Spark на VPS от AdminVPS выполняется в ручном режиме: достаточно выбрать конфигурацию, и система будет готова к использованию всего через несколько минут. Решение полностью совместимо с Ubuntu и CentOS, поддерживает интеграцию с Docker и Kubernetes, что делает процесс масштабирования удобным и быстрым.

Используя Apache Spark, компании получают надёжную инфраструктуру для работы с большими данными, гибкость при росте нагрузки и удобную интеграцию с корпоративными сервисами. Такое решение одинаково хорошо подходит как для стартапов, которым нужно быстро обрабатывать данные, так и для крупных организаций с высокими требованиями к производительности и безопасности. Всё готово к работе сразу после установки - остаётся только подключить источники данных и начать анализ.

Apache Spark на VPS

Установите Apache Spark на VPS от AdminVPS и ускорьте анализ больших данных! С нашей установкой вы получите быстрый запуск spark server, надежный сервер и экспертную поддержку. Преимущества: простота настройки, высокая производительность и безопасность для облачные spark. Закажите managed VPS прямо сейчас и начните работать с apache spark без задержек!

Преимущества Apache Spark

Spark работает поверх Java и может использовать локальный режим или кластерный запуск. Перед установкой необходимо убедиться, что сервер работает под управлением актуальной версии Ubuntu, имеет установленную Java, достаточный объём оперативной памяти и подготовленное сетевое окружение. Spark активно использует диск и RAM, поэтому правильная подготовка - ключ к стабильной работе.

Перед установкой рекомендуется очистить сервер от старых версий Java или самописных конфигураций Hadoop, если они не востребованы.

Что необходимо сделать до установки

Обновить сервер:

apt update && apt upgrade -y

Установить базовые инструменты:

apt install curl wget git nano unzip -y

Убедиться, что VPS имеет:

- • минимум 2–4 ГБ RAM

- • 2 ядра процессора

- • свободные порты 7077, 8080, 4040

Проверить установленную Java:

java -version

Если Java нет - установить OpenJDK.

-

1. Установка Java (OpenJDK)

Apache Spark требует Java 8 или выше.

Устанавливаем Java:

apt install openjdk-11-jdk -yПроверяем:

java -version -

2. Скачивание Apache Spark

Переходим в рабочую директорию:

cd /optСкачиваем последнюю стабильную версию Spark (например, 3.5.0):

wget https://downloads.apache.org/spark/spark-3.5.0/spark-3.5.0-bin-hadoop3.tgzРаспаковываем архив:

tar -xvf spark-3.5.0-bin-hadoop3.tgz

mv spark-3.5.0-bin-hadoop3 spark -

3. Настройка переменных окружения

Создаём файл:

nano /etc/profile.d/spark.sh

-

Добавляем:

export SPARK_HOME=/opt/spark

export PATH=$PATH:$SPARK_HOME/bin:$SPARK_HOME/sbinПрименяем:

source /etc/profile.d/spark.sh -

4. Запуск Spark в локальном режиме

Spark может работать без кластера - локальный режим удобен для разработки и обучения моделей.

Запуск интерфейса Spark Shell (Scala):

spark-shellЗапуск PySpark:

pysparkПосле запуска откроется интерактивная среда для работы с данными.

-

5. Запуск Spark Web UI

При запуске задач Spark открывается веб-интерфейс:

http://Ваш_IP:4040

Он позволяет отслеживать:

- • использование ресурсов

- • состояние потоков

- • задачи и стадии обработки

- • логи и ошибки

-

6. Пример тестового задания

Создаём файл:

nano test.pyПример:

from pyspark.sql import SparkSession

spark = SparkSession.builder.appName("TestApp").getOrCreate()

data = [("Alice", 25), ("Bob", 30), ("Charlie", 35)]

df = spark.createDataFrame(data, ["name", "age"])

df.show()

spark.stop()Запуск:

spark-submit test.pyЕсли всё работает - установка выполнена успешно.

| Параметр | Рекомендация | Комментарий |

|---|---|---|

| CPU | 2 ядра | Для больших задач - 4–8 |

| RAM | 4 ГБ | Для ML/ETL - 8–16 ГБ |

| Диск | от 20–40 ГБ | Spark создаёт временные файлы |

| Порты | 4040, 7077, 8080 | Web UI, master, worker |

| ОС | Ubuntu 20.04/22.04 | Оптимальная среда |

| Java | OpenJDK 11 | Полная совместимость |

Часто задаваемые вопросы

Apache Spark что это?

Apache Spark – это open-source платформа для распределённой обработки данных и машинного обучения, обеспечивающая высокую скорость вычислений и гибкость при работе с большими объёмами информации.

Какие задачи решает Spark server?

Spark используется для потоковой аналитики, построения моделей машинного обучения, обработки SQL-запросов и анализа графов.

Подходит ли Apache Spark для облачных решений?

Да, облачные Spark-сервера легко масштабируются и интегрируются с Kubernetes и Docker, что делает их удобными для бизнеса любого размера.

Что такое Spark History Server?

Это встроенный инструмент, который позволяет отслеживать выполнение задач, анализировать производительность и оптимизировать вычислительные процессы.

Apache Spark drop partition – что это?

Это функция управления разделами данных, позволяющая удалять ненужные партиции и оптимизировать хранение для повышения эффективности работы Spark.