Внимание! Техподдержка работает только через тикет-систему в личном кабинете

Apache Airflow - запускайте и управляйте рабочими процессами без ограничений

Apache Airflow - это гибкая система для планирования и выполнения сложных процессов: от ETL-конвейеров до аналитических сценариев и ML-пайплайнов.

Установив Airflow на VPS, вы получаете независимую, защищённую среду для автоматизации задач без ограничений внешних сервисов.

Все DAG-файлы, логи, настройки и данные хранятся только на вашем сервере - под полным контролем и без рисков утечки.

Apache Airflow - это удобный инструмент для автоматизации задач и управления рабочими процессами. С его помощью можно создавать цепочки операций, запускать их по расписанию, отслеживать выполнение и быстро находить ошибки.

Установив Airflow на VPS, вы получаете собственную изолированную платформу без ограничений внешних сервисов. Все данные, файлы конфигураций, логи и результаты работы хранятся только у вас - это обеспечивает безопасность и стабильность.

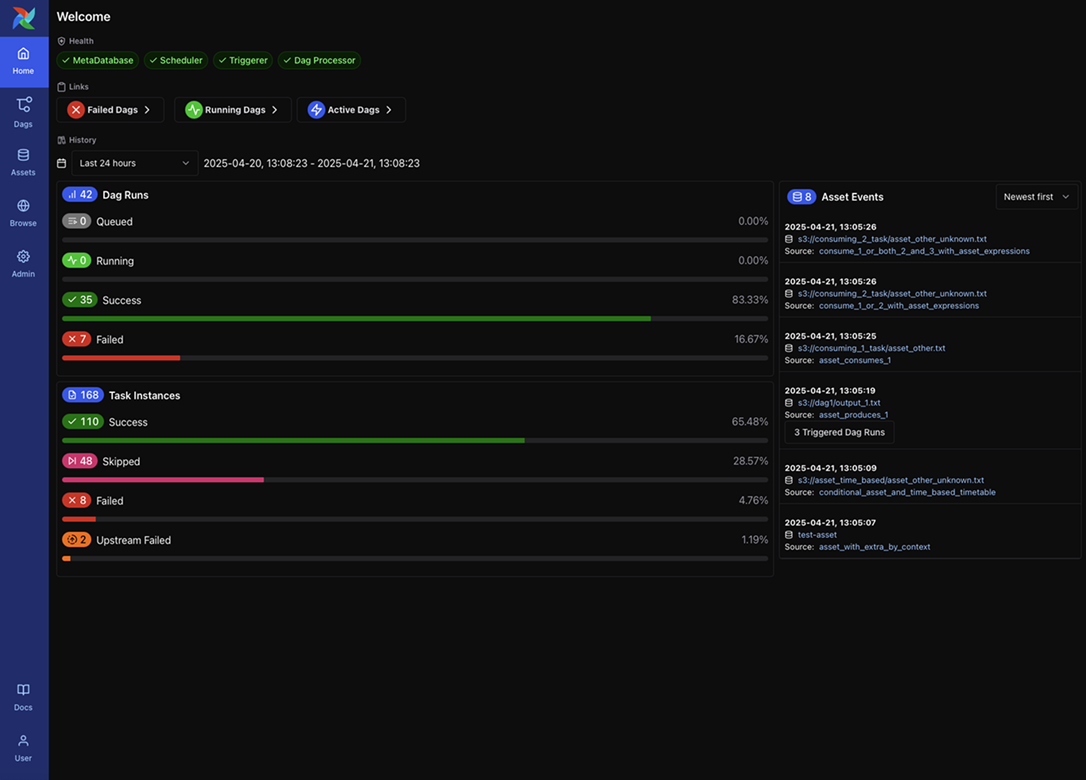

Airflow подходит для аналитиков, разработчиков, DevOps-инженеров и команд, которым важно автоматизировать процессы: сбор данных, обработку файлов, загрузку в БД, обучение моделей, интеграцию с API и другие задачи. Благодаря интерфейсу Airflow вы можете легко контролировать работу DAG, перезапускать шаги, управлять зависимостями и отслеживать состояние ваших процессов в реальном времени.

Автоматизируйте процессы с Apache Airflow под полным контролем

Airflow на VPS позволяет запускать задачи по расписанию, отслеживать выполнение и быстро находить ошибки. Все вычисления и хранилища расположены на вашем сервере - безопасно и автономно.

Преимущества Apache Airflow

Airflow работает на Python, использует базу данных (PostgreSQL или SQLite) и запускает сервисы Scheduler и Webserver, поэтому важно заранее подготовить сервер. Для стабильной работы требуется корректное окружение Python, отдельный виртуальный environment, настроенная база данных, доступные порты и достаточный объём памяти.

Перед установкой рекомендуется использовать Ubuntu 20.04 или 22.04 - эти системы полностью совместимы с Airflow.

Что необходимо сделать заранее

1. Обновить сервер:

apt update && apt upgrade -y

2. Установить Python, pip и необходимые пакеты:

apt install python3 python3-pip python3-venv build-essential libpq-dev -y

3. Проверить, что VPS имеет:

- • минимум 2 ГБ RAM

- • 10–20 ГБ дискового пространства

- • свободный порт 8080

4. Подготовить доменное имя (опционально, если понадобится HTTPS).

После настройки окружения можно переходить к установке Airflow.

-

1. Создание рабочего каталога и виртуального окружения

mkdir -p /opt/airflow

cd /opt/airflow

python3 -m venv venv

source venv/bin/activate -

2. Установка зависимостей и Airflow

Airflow требует специальных ограничений для совместимости:

export AIRFLOW_VERSION=2.8.0

export PYTHON_VERSION="$(python3 -V | awk '{print $2}')"

export CONSTRAINT_URL="https://raw.githubusercontent.com/apache/airflow/constraints-${AIRFLOW_VERSION}/constraints-${PYTHON_VERSION}.txt"Устанавливаем Airflow:

pip install "apache-airflow==${AIRFLOW_VERSION}" --constraint "${CONSTRAINT_URL}" -

3. Инициализация базы данных Airflow

По умолчанию используется SQLite, но для большинства задач этого достаточно.

Инициализируем базу:

airflow db init -

4. Создание административного пользователя

airflow users create \

--username admin \

--firstname Admin \

--lastname User \

--role Admin \

--email admin@example.comПосле этого Airflow готов к запуску.

-

5. Запуск Airflow Webserver и Scheduler вручную

Webserver:

airflow webserver -p 8080Scheduler:

airflow schedulerПанель будет доступна по адресу:

http://Ваш_IP:8080

-

6. Создание сервисов systemd (автозапуск)

Создаём сервис Webserver:

nano /etc/systemd/system/airflow-webserver.serviceСодержимое:

[Unit]

Description=Airflow Webserver

After=network.target

[Service]

User=root

WorkingDirectory=/opt/airflow

Environment="PATH=/opt/airflow/venv/bin"

ExecStart=/opt/airflow/venv/bin/airflow webserver -p 8080

Restart=always

[Install]

WantedBy=multi-user.target -

Создаём сервис Scheduler:

nano /etc/systemd/system/airflow-scheduler.service[Unit]

Description=Airflow Scheduler

After=network.target

[Service]

User=root

WorkingDirectory=/opt/airflow

Environment="PATH=/opt/airflow/venv/bin"

ExecStart=/opt/airflow/venv/bin/airflow scheduler

Restart=always

[Install]

WantedBy=multi-user.targetАктивируем:

systemctl daemon-reload

systemctl enable airflow-webserver

systemctl enable airflow-scheduler

systemctl start airflow-webserver

systemctl start airflow-schedulerТеперь Airflow работает постоянно.

| Параметр | Рекомендация | Комментарий |

|---|---|---|

| CPU | 2 ядра | Для продакшена - 4–6 |

| RAM | 2–4 ГБ | Для крупных DAG - от 8 |

| Диск | 20–40 ГБ | Логи занимают много места |

| Порт | 8080 | Панель Airflow Web UI |

| ОС | Ubuntu 20.04/22.04 | Полная совместимость |

| Python | 3.8–3.11 | В зависимости от версии Airflow |

Часто задаваемые вопросы

Что такое Apache Airflow и для чего он нужен?

Apache Airflow – это система управления рабочими процессами (workflow), которая позволяет автоматизировать запуск задач, строить DAG-и, отслеживать выполнение процессов и работать с данными. Подходит для ETL, аналитики, скриптов, ML-пайплайнов и интеграций.

Подходит ли VPS для запуска Apache Airflow?

Да. VPS – оптимальная среда: выделенные ресурсы, стабильная работа, отсутствие ограничений и полный контроль над конфигурацией Airflow.

Какая конфигурация сервера нужна для Airflow?

Базово достаточно 2 CPU, 2–4 ГБ RAM и 20–40 ГБ SSD. При увеличении количества задач, DAG-ов и воркеров ресурсы можно расширять в несколько кликов.

Можно ли подключить базу данных к Airflow на VPS?

Да. Airflow поддерживает PostgreSQL, MySQL, SQLite и внешние БД. В рабочей среде чаще используется PostgreSQL.

Доступны ли Docker и Celery Executor на VPS?

Да. Вы можете установить Airflow через Docker Compose и использовать Celery для распределённой обработки задач.