Ещё недавно сама мысль о том, что компьютер способен сочинять музыку, казалась фантастикой. Сегодня нейросети выступают в роли композиторов, аранжировщиков и даже поэтов. Разберёмся, как это работает, что умеют такие системы и где они уже применяются.

Музыка — один из самых выразительных языков человека. Мы привыкли, что за каждым аккордом, за каждой дрожащей нотой стоит чьё-то чувство: любовь, тоска, вдохновение. И вот возникает машина, лишённая чувств, но умеющая передавать эмоции и затрагивать струны души человека. Как такое возможно?

Нейросети не просто подражают — они учатся, анализируют, «впитывают» классику, поп-музыку, джаз и синтпоп, разбирают музыку на молекулы ритма, тембра и структуры. И когда их «натренированный мозг» начинает выдавать звучание, которое цепляет слух и вызывает мурашки, становится ясно: мы стоим на пороге новой музыкальной эпохи. Это уже не просто забава для энтузиастов. Искусственный интеллект сочиняет музыку для кино, игр, подкастов, рекламы. Помогает авторам преодолеть творческий ступор. Даже делает джем-сессии — в паре с человеком. Возникает вопрос: чего в этом больше — волшебства или математики?

А для тех, кто хочет пойти дальше и не зависеть от внешних сервисов, музыкальные нейросети можно развернуть прямо на своём сервере с GPU. Это открывает доступ к тонкой настройке, полной приватности данных и возможности обучить модель под конкретные задачи — например, под собственный стиль, жанр или библиотеку звуков.

Что значит «нейросеть пишет музыку»

В основе — искусственные нейронные сети, обученные на тысячах музыкальных треков. Они выявляют повторяющиеся паттерны — от гармоний и ритмов до особенностей конкретных жанров и авторских стилей.

Существуют два подхода:

- Символическая генерация — работа с нотами и MIDI (музыка в виде условных знаков).

- Аудиогенерация — создание звука напрямую, на уровне волны (Raw Audio).

Некоторые модели создают музыку с нуля, другие — продолжают заданный отрывок или имитируют стиль. Первые алгоритмы были примитивны, но с развитием нейросетей музыка стала звучать всё реалистичнее.

Как устроены музыкальные нейросети

Вопрос о том, как устроены музыкальные нейросети, — не только технический, но и по-своему поэтичный. Ведь чтобы сочинять музыку, машине нужно научиться слышать её — не в привычном нам смысле, а как набор закономерностей, ритмических паттернов, гармонических переходов. Нейросеть — это не волшебная коробка, а сложный алгоритм, который сначала «впитывает» тысячи треков, а затем пытается вывести из них логичные правила построения мелодий и ритмов.

Разные архитектуры справляются с этим по-разному. Одни нейросети генерируют ноты и аккорды, словно пишут партитуру, другие сразу синтезируют звук, как будто играют на инструменте. Есть модели, которые создают музыку шаг за шагом, помня предыдущие ноты, а есть такие, которые «видят» композицию целиком и собирают её как мозаику. От выбора архитектуры зависит, насколько «живой» получится трек — будет ли он логичным, интересным, неожиданным.

Музыкальная нейросеть — это одновременно математик и художник, вечно балансирующий между порядком и вдохновением. В следующих разделах мы разберём, какие подходы лежат в основе таких систем и как они преобразуют шум и хаос в звучание, способное зацепить.

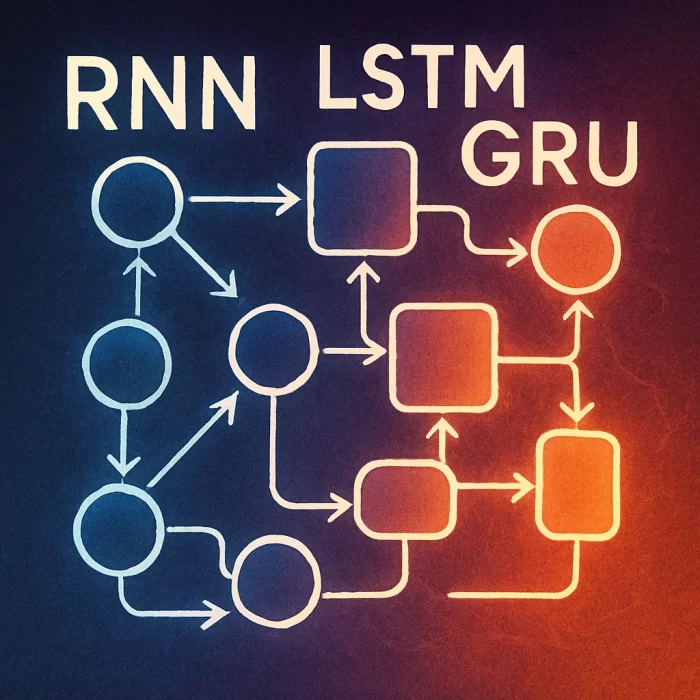

Рекуррентные сети (RNN, LSTM, GRU)

Рекуррентные нейросети — одни из первых моделей, научившихся «слушать» и генерировать музыку. Их суть проста: они воспринимают музыку как цепочку событий, где каждая следующая нота зависит от предыдущей. Представьте себе пианиста, который играет мелодию на слух, запоминая, что он только что сыграл, чтобы подобрать следующую ноту. Примерно так устроена работа RNN.

Чем дольше продолжается музыка, тем сложнее сети удерживать «память» о начале. На коротких отрывках она звучит связно: можно уловить ритм, повторяющиеся мотивы, логичную гармонию. Но как только мелодия становится длиннее, модель начинает забывать, с чего всё началось. Композиция может стать сбивчивой, потерять направление — словно рассказ, который вдруг перестаёт иметь смысл.

Чтобы расширить «память» таких моделей, были созданы более совершенные архитектуры — LSTM и GRU. Они умеют дольше удерживать контекст и лучше справляются с длинными музыкальными фразами. Но даже они ограничены: у них всё ещё нет глобального «взгляда» на композицию, только шаг за шагом, как если бы человек сочинял, не отрывая глаз от одной строчки нотного стана. Именно поэтому позже на сцену вышли трансформеры.

Трансформеры

Трансформеры — это архитектуры, которые произвели революцию не только в обработке текста, но и в генерации музыки. Их главное отличие от рекуррентных сетей — в способности «видеть» всю композицию целиком, а не только предыдущие ноты. Вместо того чтобы шаг за шагом вспоминать, что было до этого, трансформеры сразу анализируют всю музыкальную последовательность — как будто смотрят на нотный лист сверху, охватывая его взглядом полностью.

Ключевая особенность трансформеров — механизм внимания (attention). Он позволяет модели определять, какие части музыкального произведения важны в конкретный момент. Например, если в начале была мелодическая тема, трансформер может снова к ней вернуться через сотню тактов, чтобы построить гармоничную репризу или варьировать мотив — почти как это делает композитор, держащий всю структуру в голове.

Один из ярких примеров — Music Transformer от команды Magenta (Google). Эта модель умеет генерировать реалистичные фортепианные пьесы с динамикой, паузами, акцентами и длительностью нот. Получается музыка, в которой чувствуется дыхание, развитие и логика — не просто последовательность звуков, а настоящая история. Благодаря такой архитектуре трансформеры стали основой для самых продвинутых музыкальных нейросетей, особенно когда важна структура и длительность трека.

Генерация звука напрямую

Если предыдущие модели работали с нотами, как с текстом — записывали партитуру, которую потом должен исполнить виртуальный инструмент, — то следующий уровень нейросетей научился генерировать звук напрямую. Это уже не запись нот, а создание самой звуковой волны — точка за точкой, словно музыка вырастает из шума. Такой подход требует колоссальных вычислительных ресурсов, но результат — гораздо ближе к тому, что слышит человек.

Один из пионеров в этой области — WaveNet, разработанный компанией DeepMind. Изначально эта модель создавалась для синтеза речи, чтобы голос в смартфоне или колонке звучал живо и естественно. Но вскоре оказалось, что та же технология может синтезировать и музыку. WaveNet предсказывает амплитуду звукового сигнала с невероятной точностью, создавая плавное, натуральное звучание — словно играет живой инструмент.

Следующий шаг сделала OpenAI с моделью Jukebox. В отличие от систем, работающих с MIDI, Jukebox генерирует полноценные аудиотреки, включая вокал, стиль исполнения, тембр голоса и даже интонации. Она обучалась на огромной базе песен самых разных жанров — от классики и рока до рэпа и поп-музыки — и способна создавать треки в духе ретро-рока, современной поп-сцены или тяжёлой гитарной музыки. Конечно, пока результат звучит «сыровато», но сама идея поражает: машина создаёт не просто музыку, а почти готовую песню с голосом и характером.

Это уже не просто инструмент — это попытка воссоздать сам процесс исполнения, с интонациями, дыханием и настроением. В этом — огромный шаг вперёд: нейросеть перестаёт быть «писателем нот» и становится виртуальным исполнителем.

Примеры нейросетей-музыкантов

Современные музыкальные нейросети — это уже не лабораторные прототипы, а вполне доступные инструменты, которыми пользуются композиторы, разработчики игр, видеомейкеры и просто творческие люди. Вот несколько ярких примеров:

Magenta (Google Brain)

Magenta — исследовательский проект от Google, в котором собраны открытые инструменты для генерации музыки и других видов творчества. Среди них:

- MusicVAE — нейросеть, которая умеет создавать вариации мелодий, а также «плавно» превращать одну музыкальную фразу в другую.

- AI Duet — простой веб-инструмент, где ИИ отвечает вам на клавишные фразы, создавая ощущение живого диалога.

- Music Transformer — мощная модель, генерирующая сложные фортепианные пьесы в заданном стиле. Подходит для более глубокой композиционной работы.

Magenta особенно ценна тем, что её инструменты можно протестировать в Google Colab — прямо в браузере, без сложной установки.

MuseNet и Jukebox (OpenAI)

Компания OpenAI предложила сразу два разных подхода к музыкальному ИИ:

- MuseNet работает с MIDI и может генерировать композиции в жанрах от классики до джаза. Она подражает стилю известных композиторов и групп, комбинируя инструменты и жанры.

- Jukebox пошла дальше: эта модель создаёт готовые аудиотреки с вокалом, учитывая стиль, тембр, ритм, даже «манеру исполнения». Это один из самых впечатляющих примеров генеративной музыки на сегодняшний день.

На сайте OpenAI можно послушать примеры Jukebox — от лирических баллад до тяжёлого рока. Звучание ещё неидеально, но потенциал огромен.

AIVA (Artificial Intelligence Virtual Artist)

AIVA — это сервис, который позиционирует себя как ИИ-композитор. Он пишет симфонии, инструментальные треки и фоновые композиции для фильмов, видеоигр, рекламы. Пользователь может задать стиль (например, классика, эпик, эмбиент), структуру (куплет — припев) и получить результат в виде MIDI или аудио, пригодный для аранжировки и доработки. Отлично подходит для саунд-дизайнеров и медиа-проектов.

Amper Music и Ecrett Music

Это примеры коммерческих онлайн-сервисов, ориентированных на пользователей без музыкального образования:

- Amper Music позволяет создавать саундтреки для видео, подкастов и других проектов. Пользователь задаёт параметры — настроение, стиль, длительность — и получает готовую композицию.

- Ecrett Music работает по схожему принципу: выбираешь жанр (от медитации до экшена), задаёшь настроение — и система генерирует трек, который можно адаптировать под нужды проекта.

Такие платформы особенно популярны среди блогеров, разработчиков и маркетологов, которым нужна музыка «здесь и сейчас», без необходимости в долгой работе с композитором.

Генерация текстов песен

Музыка — это не только мелодия, но и слова. Именно они делают песню запоминающейся, эмоционально окрашенной, смысловой. И здесь в игру вступают языковые модели вроде GPT-4o, BERT, T5 и других, обученных на огромных массивах текстов, в том числе песен самых разных жанров.

Такие модели умеют писать лирику в заданном стиле: будь то хип-хоп с рифмами и сленгом, поп-баллада с романтичным подтекстом или мрачный рок с философским настроением. Они понимают, как устроена песня: где начинается куплет, когда должен прозвучать припев, как повторяется рефрен. При желании можно задать даже настроение или ключевые слова — модель подберёт строки, рифмы и образы под нужный запрос.

Да, на уровне глубоких смыслов и поэтической образности такие тексты пока уступают творчеству настоящих авторов — не хватает эмоциональной многослойности, метафор, культурных отсылок. Но для фоновой музыки, джинглов, рекламных песен или черновиков — это уже рабочий инструмент. Многие музыканты используют ИИ как соавтора: задают идею, получают варианты, а потом редактируют, добавляют индивидуальность и глубину. Это скорее соавтор, чем конкурент — и с этой ролью он справляется.

Как использовать нейросеть для музыки

Выбор инструмента:

- Нужны партитуры — используйте AIVA, MuseNet.

- Требуется аудиофайл — подойдут Jukebox, WaveNet.

- Хотите экспериментировать — попробуйте Magenta и Google Colab.

Подготовка данных для:

- обучения — нужны большие наборы MIDI или аудио;

- быстрой работы — лучше использовать готовые модели.

Постобработка:

- проверить мелодичность,

- подкорректировать фрагменты,

- провести мастеринг — пока без этого не обойтись.

Сравнение различных по назначению музыкальных нейросетей

| Цель | Что нужно получить | Подходит | Формат вывода | Уровень пользователя |

|---|---|---|---|---|

| Композиторская работа, оркестровка | Ноты, партитуры, вариации | AIVA, MuseNet, MusicVAE (Magenta) | MIDI | Средний/Продвинутый |

| Генерация готового трека с вокалом | Полноценный аудиофайл | Jukebox (OpenAI) | Аудио (MP3) | Продвинутый |

| Создание фоновой музыки под видео | Быстрый трек «под ключ» | Amper Music, Ecrett Music | Аудио | Начинающий |

| Генерация мелодий и аккордов для идей | Базовая музыкальная структура | Music Transformer (Magenta), AI Duet | MIDI или онлайн-игра | Начинающий/Средний |

| Автоматическая генерация текстов песен | Лирика в нужном жанре и стиле | GPT-4-turbo, GPT-4o, T5 | Текст | Любой |

| Эксперименты с нейросетями, обучение | Свободный доступ, возможность доработки | Magenta (Google Colab) | MIDI/Code/Интерфейс | Средний/Продвинутый (Python) |

| Синтез реалистичного инструмента или речи | Натуральное звучание | WaveNet (DeepMind) | Аудио | Продвинутый |

Ограничения нейросетей для создания музыки

Несмотря на впечатляющие успехи, нейросетевые модели пока далеки от универсального музыкального интеллекта. Они работают по заданным алгоритмам и не обладают креативностью в человеческом понимании. Использование ИИ в музыке по-прежнему сопряжено с рядом ограничений — как технических, так и концептуальных. Например, это:

- Повторы и однообразие. Нейросети склонны к генерации повторяющихся структур, особенно если обучающий датасет был узким по стилю или некачественно размечен. Это снижает оригинальность и делает музыку предсказуемой.

- Синтетический вокал. Даже самые продвинутые модели пока не способны достоверно передать нюансы человеческого голоса — дыхание, эмоции, тембровую глубину. Вокал звучит «искусственно», теряет живость.

- Авторское право. Если модель обучалась на защищённых произведениях, остаются вопросы: кому принадлежат сгенерированные треки? Использование таких моделей в коммерческих целях может нарушать закон.

- Отсутствие художественного намерения. ИИ не понимает смысла и не формулирует концепции — он не композитор в полном смысле слова. Это инструмент, умеющий анализировать и воспроизводить формы, но не создавать идейно выстроенные произведения.

- Сложность управления. Даже при точных параметрах сложно предсказать результат генерации. Модели не всегда воспроизводят задуманное настроение, структуру или ритм — особенно если запрос абстрактный.

- Высокие ресурсоёмкость и требования. Модели, генерирующие аудио напрямую (например, Jukebox), требуют значительных вычислительных мощностей и времени. Это ограничивает их использование в реальном времени или на слабых устройствах.

- Языковые и жанровые ограничения. Большинство моделей лучше справляются с англоязычным контентом и мейнстрим-жанрами. Музыка на других языках, редкие стили или этнические формы могут быть искажены или вообще не поддерживаться.

Нейросети и человек: союз, а не замена

ИИ не вытесняет музыкантов — он становится их партнёром. Он помогает:

- быстро набросать гармонию,

- сгенерировать идеи,

- создавать музыку тем, кто не владеет теорией.

В будущем — более реалистичные голоса, «живое» взаимодействие с исполнителями и виртуальные оркестры. Но уже сегодня ясно: это не мода, а новая эпоха в музыкальном творчестве.

Вывод

Нейросети в музыке способны ускорить творческий процесс и расширить его границы. Они не заменяют человека, но усиливают его идеи. Там, где алгоритм встречается с вдохновением, рождаются удивительные вещи.

Читайте в блоге:

- Новые крутые нейросети для творчества, аналитики, разработки

- Как выбрать виртуальный сервер для сложных задач: гайд по GPU-решениям

- Виды нейронных сетей: примеры для бизнеса и личного использования