Один лишний слеш — и сайт может пропасть из выдачи. Объяснили, как настроить robots.txt: что писать, как проверять и зачем вообще всё это нужно.

Когда поисковые боты заходят на сайт, они не читают его как человек. Им нужны чёткие указания: что открывать, а что пропустить. И именно здесь в игру вступает файл robots.txt. Его часто игнорируют или настраивают по шаблону, а зря. Этот материал пригодится тем, кто размещает сайты в Интернете — будь то shared-хостинг, выделенный сервер или VPS. В статье рассказали, как создать и правильно настроить robots.txt, чтобы поисковики видели главное, а не блуждали по служебным разделам и не теряли фокус на главном. Объяснили, зачем он вообще нужен, как его оформить, какие ошибки встречаются чаще всего и как не потерять трафик.

Зачем нужен robots.txt и как он влияет на SEO

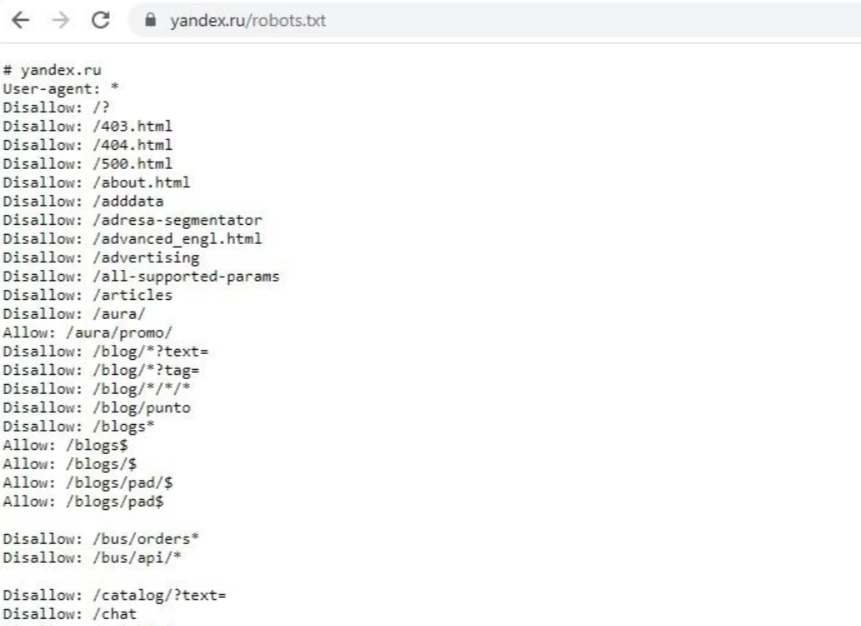

Поисковые системы работают быстро, но не бесконечно внимательно. У каждого сайта есть так называемый краулинговый бюджет — ограниченное количество страниц, которые бот может обойти за один заход. И если он тратит его на технические папки, фильтры или копии страниц, до важного контента он может просто не дойти.

Файл robots.txt помогает направить поисковика туда, где действительно есть что индексировать. Он не влияет напрямую на позиции в выдаче, но управляет доступом к страницам — это определяет, что именно попадёт в индекс. Его роль — задать границы: показать, какие разделы стоит обходить стороной, а какие наоборот открыты для сканирования.

С его помощью можно закрыть от лишнего внимания страницы логина, корзины, черновики, дубли страниц с фильтрацией или экспериментальные разделы сайта. Это делает индексацию чище и помогает поисковой системе быстрее понять суть и структуру проекта.

Как создать и разместить файл robots.txt

Файл robots.txt можно создать в любом текстовом редакторе, главное сохранить его без дублированных расширений вроде .txt.txt, которые иногда проскальзывают, особенно в Windows-системах. Название должно быть строчным, без пробелов и лишних символов: robots.txt. Кодировку лучше сразу выставить как UTF-8 без BOM, иначе поисковые боты могут некорректно считать файл, особенно если в нём будут нестандартные символы или кириллица.

Когда файл готов, его нужно положить в корень сайта. Это та же папка, где лежит главная страница. Если всё сделано правильно, robots.txt будет доступен по адресу вида https://example.com/robots.txt. Откройте этот путь в браузере — если файл не отображается, значит поисковик его тоже не найдёт.

Если у сайта есть несколько зеркал или поддоменов, проверьте, где именно расположен основной домен, и убедитесь, что файл лежит именно там. Например, если основной адрес с www, файл должен быть доступен по адресу с www. И наоборот: если рабочая версия без www, то и robots.txt нужно разместить на этом домене.

Изменения в robots.txt применяются сразу после загрузки файла на сервер. Никаких дополнительных действий не требуется, но можно вручную проверить доступность файла, а позже прогнать его через инструменты вроде Google Search Console или «Яндекс Вебмастер», чтобы убедиться, что всё читается корректно.

Что именно писать в robots.txt

Все настройки задаются через директивы — короткие команды, которые читаются построчно. Первой указывается директива User-agent, она обозначает, для какого поискового робота пишутся правила. Если указать *, инструкции применятся ко всем ботам сразу: и к Googlebot, и к «Яндексу», и к другим. Такой вариант используется чаще всего.

Дальше идут директивы Disallow и Allow. С их помощью вы показываете, к каким разделам стоит ограничить доступ, а какие можно сканировать. Например, закрыть от индексации папку с личным кабинетом или корзиной, а блог или каталог товаров оставить открытыми. Адреса в этих строках указываются относительно корня сайта, без домена. Если после Disallow не указать путь, доступ будет разрешён ко всем страницам. Если указать /, всё заблокируется.

Дополнительно можно добавить директиву Sitemap. Она указывает на карту сайта и помогает роботам быстрее находить важные страницы. Адрес нужно прописывать полный, с протоколом и доменом. Иногда также используется Host — она сообщает «Яндексу», какой домен считать основным.

Вот как может выглядеть простой, но рабочий пример: закрыт доступ к /admin/, открыт раздел блога, а в конце указан путь к карте сайта. Пример:

User-agent: *

Disallow: /admin/

Allow: /blog/

Sitemap: https://example.com/sitemap.xml

Host: example.comВсе директивы пишутся вручную. После сохранения файл загружается в корневую директорию, и если перейти по адресу https://example.com/robots.txt, вы должны увидеть именно этот текст. Изменения вступают в силу сразу. Поисковые роботы проверяют файл при следующем обходе, и с этого момента начинают учитывать новые ограничения и рекомендации.

Как проверить robots.txt на проде без риска

Перед применением изменений в robots.txt полезно протестировать их в изолированной среде. Один из способов — временно разместить файл на тестовом домене с той же структурой и прогнать его через инструменты проверки в Google Search Console или «Яндекс Вебмастере». Инструменты покажут, как поисковик прочитает правила, не затрагивая основной сайт.

Если тестового домена нет, можно использовать эмуляторы вроде SEOptimer и TechnicalSEO. Они позволяют вставить текст вручную и посмотреть, будет ли путь разрешён или заблокирован.

Также можно воспользоваться curl прямо из терминала:

curl -I https://example.com/robots.txtТак вы убедитесь, что файл доступен, загружается без ошибок и возвращает корректный код ответа 200. Если сервер отдаёт редирект, 403 или 404, бот его не увидит.

Частые ошибки в настройке

Ошибки в robots.txt проявляются не сразу. Сначала поисковик не находит нужные страницы, потом перестаёт обновлять старые, а позже сайт теряет позиции. Причина часто простая — случайно закрыли нужный раздел или весь сайт.

Одна из самых частых ошибок — директива Disallow: /, оставшаяся после разработки. Её забывают удалить, и поисковик теряет доступ ко всему проекту. Пустой файл тоже опасен. Он как будто разрешает всё, но не даёт боту подсказок о структуре.

Иногда блокируют CSS, JS или изображения. Без них бот видит страницу как скелет. Визуальная структура нарушается, и это снижает оценку качества.

Бывает, что сам файл недоступен. Он может лежать не в корне, иметь неправильное имя или просто не открываться. Если при переходе на example.com/robots.txt появляется ошибка, поисковик работает вслепую.

Файл стоит проверять руками и через Google Search Console или «Яндекс Вебмастер». Если видите предупреждение, лучше сразу внести правки.

Файл robots.txt недостаточно настроить один раз. При каждом изменении структуры сайта его стоит пересматривать. Иначе можно случайно открыть лишнее или закрыть важное.

Если редактируете вручную, делайте резервные копии. Одна ошибка в строке может закрыть доступ ко всему сайту для поисковых роботов. Особенно важно это для систем, где файл генерируется автоматически.

Хорошая привычка — проверять robots.txt при каждом крупном обновлении. Добавили раздел — решите, индексировать его или нет. Убрали — проверьте, не остался ли он в правилах.

Заключение

Правильно настроенный robots.txt — это способ держать сайт в фокусе поисковых систем. Он помогает исключить лишние страницы из индекса, сфокусировать внимание поисковика на важном и экономить краулинговый бюджет. Когда файл написан осознанно, становится проще управлять видимостью проекта и не бояться, что важные страницы останутся в тени. Этот маленький документ играет большую роль в том, как поисковики видят ваш проект.

Читайте в блоге:

- Где находится robots.txt в WordPress и как правильно его использовать

- Как добавить сайт в поисковики

- Как использовать нейросети в SEO-оптимизации